オーディオ化ってしてますか?

バウンスとかミックスダウンとか。

バウンスやミックスダウンについてはこちら。

ボクは曲を創りはじめた頃には、オーディオ化する意味ってのがよくわかりませんでした。

なぜなら、ボクは楽器を使わないDTMerだから。

つまりDAW上でしか、音を出さないから。

音源プラグインのみでしか音を創らないから。

何なら、完全無欠正真正銘DTMerとも言えるのではないか?

いや、言わないか?

ということは、当然、MIDIで打ち込むわけです。

MIDIで打ち込むのに、オーディオ化とかしてしまったら、変更できないじゃないですか。

当然、MIDIが消えてなくなるわけではないので、修正ができないわけではないですが、修正するたびにオーディオ化しなくてはいけなくなるわけです。

面倒です。

ということは、全部、MIDIのままでいいじゃん、ってなりますよね。

そのままミックス、マスタリングまでやったって、問題ないじゃないか。

・・・と思っていたわけです。

が、やっぱりオーディオ化は必要だったんですね。

その理由を3つほど書いておきます。

1.パソコンの性能の限界

曲を創り始めた頃は、全く問題なかったんですけどね・・・

最初の頃は、トラックなんて、10もなかったわけです。

というか、なぜトラックが増えるのかもわかりませんでした。

そんな状態から始まって、使う音源の数が増えていって、使うエフェクターの数が増えていって・・・

すると、だんだんCPUやメモリが悲鳴をあげてくるようになります。

まぁ、全ての音源を、全てのエフェクターをPCが動かしているんですから、無限に使用することはできないわけです。

CPUの性能や、メモリの容量によって、このあたりの限界は変わってきますので、どれだけできるかは、使用しているPCによって変わります。

プラグインによって、負荷のかかり具合も異なります。

となると、PCの性能の範囲内で曲を創らないといけなくなります。

これは困るわけですよね。

ということで、ここでオーディオ化。

音源プラグインで創った曲をオーディオ化してしまうと、もう、変更できません。

(まぁ、オーディオファイルを編集するプラグインなどもありますけど・・・)

しかし、もう完成しているならば、変更する必要がないならば、負荷のかかるプラグインをずっと動かしておく必要はないんですよね。

だから、完成したものは、オーディオ化してしまう。

そして、「トラックを無効化(Studio Oneの場合)」をしてしまうと、そのプラグインによる負荷はなくなります。

つまり、新しいプラグインを立ち上げることができます。

まぁ、このあたりは、PCの性能によります。

可能であれば、作曲、編曲段階では、オーディオ化しない方が便利なことの方が多いです。

2.音の確定

オーディオ化すると、もう変更ができないと書きました。

つまり、オーディオ化するということは、音を確定することです。

となると、オーディオ化をした「結果」が音の確定なのではないか、と思われるかもしれません。

しかし、逆に、音の確定がオーディオ化の「目的」ともなりうる場合があります。

なぜかというと、一部のプラグインには「ランダム機能」があるからです。

これは、音源プラグインにも、エフェクタープラグインにも、ついている場合があります。

特に、音源プラグインのランダム機能は、結構、影響が大きいです。

例えば、無料シンセのVital。

この右下の方の「RAND」というのが、ランダム機能です。

これを、例えばボリュームに割り当ててみます。

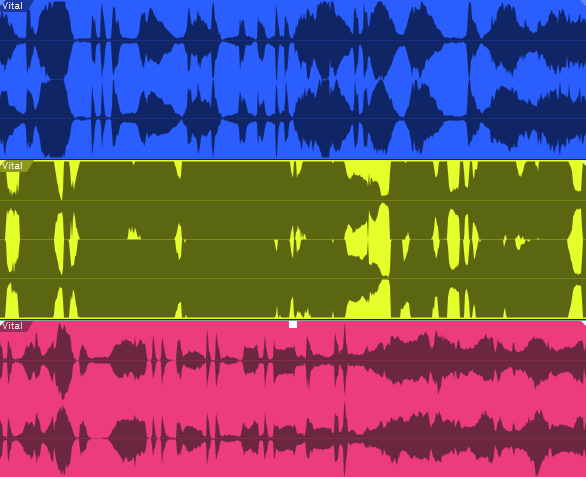

で、これをバウンスしたのがこちら。

この3つは、全て同じMIDIトラックをバウンスしたものです。

当然、ランダムに音量が調整されるので、再生するたびに、音が変わるわけです。

そうなると、ここにエフェクターをかけたときの設定も変わってきますよね。

もちろん、こんな極端にランダムを割り当てることもないとは思いますが、これはもう、別の音と考えるべきですよね。

ちなみに、ランダム機能とは関係なくても、音源プラグインでも、エフェクタープラグインでも、多少のブレっていうのはあるみたいです。

まぁ、多少のブレは影響は少ないでしょうけど、特にランダムが割り当てられているときは、最低限、エフェクターを挿す前に、まずは音を確定することが必要になってきます。

これが、音の確定を「目的」とする場合ですね。

3.音のずれの修正

さて、これは、音の確定と同じと言えば同じなんですが、別の項目として書いておきます。

音源プラグインだけでも起こる問題ではあるのですが、エフェクタープラグインで特に起こりやすい問題です。

パソコン上で曲を創っているとついつい忘れがちなことです。

これが、実機(ハード)であれば、意識しやすいかもしれません。

曲を創るなかで、エフェクターを大量に挿す場合もあると思います。

まぁ、1つでも、起こりうる話なんですけど・・・

エフェクターって、音をエフェクターに入れて、エフェクター内で色々な処理をして、再び音を出すものですよね。

インプットとかアウトプットとかありますよね。

インプット、エフェクト、アウトプットを行うにあたり、当然、処理をするための時間が必要なんです。

つまり、こんな感じです。

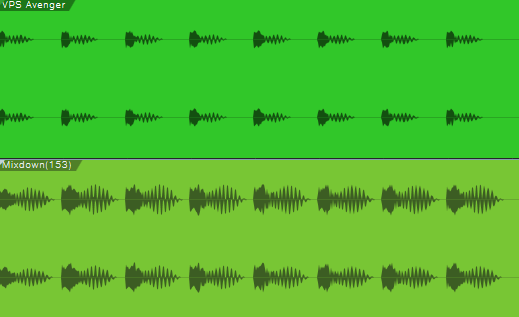

キックになんやかんやとエフェクターを挿してみました。

上が元の音、下がエフェクターを挿した音。

はっきりと音が変わっているのが、オーディオファイルにすると、よくわかりますね。

まぁ、ここで、大事なのは、変わっているのがわかるという話ではないんです。

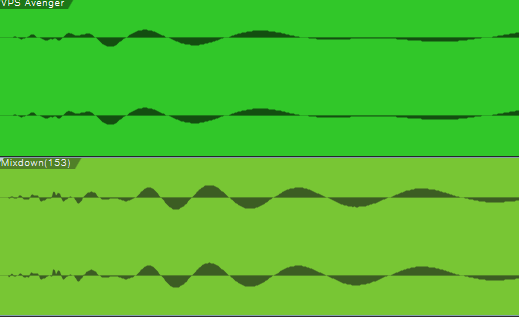

拡大してみます。

はい、見ていただくとわかるかと思いますが、上と下で音にずれが生じているのがわかるでしょうか。

もっと、わかりやすく、ずれるエフェクターを見つけられたら良かったんですが、微妙ですね・・・

とはいえ、このようにエフェクターを挿すと、音がずれる場合があります。

さらに言えば、音源プラグイン自体にも、ずれが生じる場合があります。

小節の頭にMIDIを置いておくと、当然、小節の頭から音が鳴ると思いますよね。

これが、そうでもないんです。

で、単体であれば、それほど問題はないんですが、例えば、キックを重ねたり、キックと同時に他の音を鳴らしたりする時ですね。

ものすごく微妙にずれていたりします。

なんなら、はっきりずれている場合もあります。

これが、耳で聴いて、別に不自然でないならよいのですが、やはりちょっとおかしい、となる場合もあります。

もちろん、位相の干渉って問題もあるので、タイミングのずれだけではなく、音が変わることもあります。

まぁ、どこまで厳密にしないといけないかというのも、個人によって異なるでしょうが、とりあえず、自分で聴いていておかしいものは直さないと気持ち悪いですよね。

ということで、これについては、エフェクターを挿した後、マスタリングの前には音を確定して、確認したいところですね。

まとめ

ということで、オーディオ化の目的について書きました。

こうなると、オーディオ化というのは、最低限2回しないといけない気がします。

1回はエフェクターを挿す前。

もう1回はエフェクターを挿した後、ですね。

作曲・編曲→オーディオ化→ミックス→オーディオ化→マスタリングって感じでしょうか。

まぁ、エフェクターをいつ挿すかによって状況は変わりますね。

作曲・編曲しながら、エフェクターを挿す人もいるだろうし・・・

つまりは、1つの音源について、音源プラグイントラック、元オーディオトラック、エフェクトオーディオトラックの3つがある状態なのかなぁ、と思います。

さらに言えば、全てのエフェクトオーディオトラックを1つのオーディオトラックにまとめてからマスタリングをした方が良いかもしれません。

そうなると、3回オーディオ化する必要があるのかもしれませんね。

コメント